1. 회귀 모델

1-1. 선형 회귀 모델

선형 회귀 모델(Linear Regression Model)은 종속 변수와 독립 변수 간의 선형 관계를 모델링하는 회귀 분석 알고리즘dl다. 종속 변수는 예측하고자 하는 변수이며, 독립 변수는 종속 변수를 설명하는 변수다.

선형 회귀 모델은 가장 간단하면서도 널리 사용되는 회귀 모델 중 하나이다. 이 모델은 종속 변수와 독립 변수 간의 선형 관계를 가정하고, 이 관계를 표현하는 최적의 회귀 계수를 찾아내는 것이 핵심이다.

선형 회귀 모델은 보통 최소 제곱법(Least Square Method)이나 경사 하강법(Gradient Descent Method)을 사용하여 회귀 계수를 추정한다. 최소 제곱법은 회귀 직선과 실제 데이터 간의 거리(오차)를 최소화하는 회귀 계수를 찾아내는 방법이다. 경사 하강법은 오차 함수를 최소화하는 방향으로 회귀 계수를 조금씩 조정하여 최적의 값을 찾아내는 방법이다.

선형 회귀 모델은 단순 선형 회귀 모델과 다중 선형 회귀 모델로 나눌 수 있다. 단순 선형 회귀 모델은 독립 변수가 하나인 경우를 말하며, 다중 선형 회귀 모델은 독립 변수가 여러 개인 경우를 말한다.선형 회귀 모델은 예측, 분류, 추정, 연구 등 다양한 분야에서 활용된다.

예를 들어, 주택 가격 예측, 판매량 예측, 고객 구매 예측 등 다양한 예측 문제를 해결하는 데 사용될 수 있다.

1-2. 선형 회귀 모델의 특징

1) 종속 변수와 독립 변수 간의 선형 관계를 가정한다.

- 선형 회귀 모델은 종속 변수와 독립 변수 간의 관계가 선형이라는 가정을 하기 때문에, 비선형 관계를 가지는 데이터에는 적용하기 어렵다.

2) 회귀 계수를 추정하는 방법으로 최소 제곱법 또는 경사 하강법을 사용한다.

- 최소 제곱법은 회귀 직선과 실제 데이터 간의 거리(오차)를 최소화하는 방법이다.

3) 단순 선형 회귀 모델과 다중 선형 회귀 모델로 나뉜다.

- 단순 선형 회귀 모델은 독립 변수가 하나인 경우를 말하며, 다중 선형 회귀 모델은 독립 변수가 여러 개인 경우를 말한다.

4) 잔차(Residual)의 분포가 정규 분포를 따른다는 가정을 한다.

- 잔차는 모델이 예측한 값과 실제 값의 차이를 말한다.

- 만약 잔차의 분포가 정규 분포를 따르지 않는다면, 모델이 잘못된 예측을 하고 있다는 의미다.

1-3. 선형회귀 모델의 목적

1) 예측

- 선형 회귀 모델은 입력 변수와 출력 변수 간의 선형 관계를 학습하여, 새로운 입력 데이터가 주어졌을 때 출력 변수를 예측하는 데 사용된다. 예를 들어, 주택 가격을 예측하기 위한 선형 회귀 모델은 주택의 크기, 방의 개수, 지역 등의 입력 변수를 사용하여 주택 가격을 예측할 수 있다.

2) 인과 관계 분석

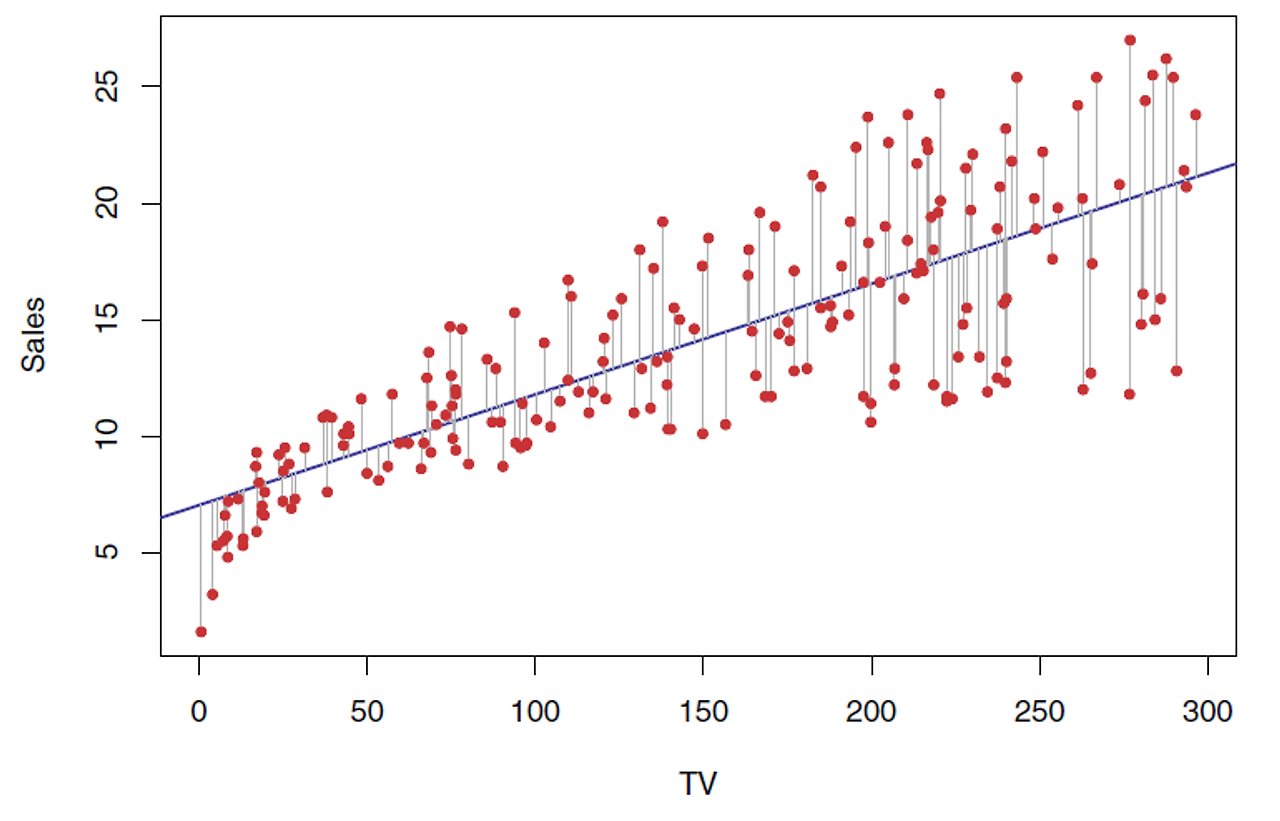

- 선형 회귀 모델은 입력 변수와 출력 변수 간의 인과 관계를 분석하는 데 사용될 수 있다. 예를 들어, 광고 비용과 판매량 간의 관계를 분석하기 위한 선형 회귀 모델은 광고 비용이 증가할 때 판매량이 어떻게 변화하는지 분석할 수 있다.

3) 이상치 탐지

- 선형 회귀 모델은 이상치를 탐지하는 데 사용될 수 있다. 예를 들어, 입력 변수와 출력 변수 간의 관계가 선형적이라고 가정했을 때, 이상치 데이터는 선형 관계를 벗어나기 때문에 이를 감지하고 제거할 수 있다.

4) 변수 선택

- 선형 회귀 모델은 변수 선택을 위해 사용될 수 있다. 입력 변수 간의 상관 관계를 분석하여, 종속 변수와 관련이 적은 변수를 제거하거나, 종속 변수와 높은 상관 관계를 가진 변수를 선택하는 데 사용될 수 있다.

2. 선형회귀 알고리즘

2-1. 단순 선형 회귀 알고리즘

단순선형회귀식은 독립 변수와 종속 변수가 1개씩인 경우 둘 사이의 인과관계를 분석하는 알고리즘이다. 최소제곱법을 활용하여 실제 데이터와 오차가 가장 작아지는 직선의 방정식을 찾는다. 따라서, 단순선형회귀식은 다음과 같은 형태를 가진다.

y는 종속 변수, x는 독립 변수β_0은 y절편, β_1은 기울기를 나타낸다. 최소제곱법을 사용하여 β_0와 β_1을 추정한 후, 이를 이용하여 종속 변수의 값을 예측할 수 있다.

2-2. 다중 선형 회귀 알고리즘

다중선형회귀식은 독립 변수가 2개 이상인 경우 둘 사이의 인과관계를 분석하는 알고리즘이다. 다중선형회귀식은 다음과 같은 형태를 가진다.

여기서, y는 종속 변수, x_1, x_2, ..., x_n은 독립 변수, β _0는 y 절편, β_1 , β_2 ..., β_n은 각 독립 변수의 기울기를 나타낸다. 최소제곱법을 사용하여 β _0, β _1, β _2, ..., β _n을 추정한 후, 이를 이용하여 종속 변수의 값을 예측할 수 있다.

2-3. 최소제곱법

최소제곱법은 주어진 데이터를 가장 잘 설명하는 직선(또는 곡선)을 찾는 방법이다. 이 방법은 데이터를 가장 잘 설명하는 선형 방정식의 계수를 찾기 위해 사용된다.

선형 회귀에서는 입력 변수(독립 변수)와 출력 변수(종속 변수) 사이의 관계를 모델링한다. 최소제곱법은 이 모델링 과정에서 주어진 데이터 포인트와 회귀선 사이의 거리(오차)를 측정하고, 이 거리를 최소화하는 회귀선을 찾는 것이다.

이를 수식으로 표현하면, 주어진 데이터 포인트들 (xi, yi)에 대해, 회귀선의 방정식이 $y = ax + b$ 라고 할 때, 최소제곱법은 다음과 같은 오차 함수를 최소화한다.

Ε(a,b) = Σ(yi - (axi + b))^2

이 식에서 Σ는 모든 데이터 포인트에 대한 합을 의미한다. 최소제곱법은 이 오차 함수를 최소화하는 a와 b 값을 찾는 것이다.

이러한 방법으로 최소제곱법을 사용하면 데이터에 가장 잘 맞는 회귀선을 찾을 수 있다. 이 회귀선은 데이터의 분포와 패턴을 가장 잘 설명하는 방법이며, 이를 통해 새로운 데이터에 대한 예측을 수행할 수 있다.

2-4. 경사 하강법

경사하강법(Gradient Descent)은 함수의 기울기(Gradient)를 이용하여 함수의 최솟값을 찾아가는 최적화 알고리즘이다. 경사하강법은 주어진 비용 함수(Cost Function)의 값이 최소가 되도록 모델의 파라미터를 조정하는 방법으로, 회귀분석에서 최소제곱법 대신에 사용되기도 한다.

경사하강법은 먼저 임의의 시작점에서 시작하여, 함수의 기울기(Gradient)를 계산하고, 그 기울기의 반대 방향으로 일정한 크기(학습률)만큼 이동합니다. 이 과정을 여러 번 반복하면서 함수의 최솟값에 근접해가는 과정을 거친다.

즉, 경사하강법은 함수의 기울기(Gradient)를 이용하여 함수의 최솟값을 찾아가는 것이며, 이를 통해 회귀분석에서는 최소제곱법과 비슷하게 오차 함수(Error Function)를 최소화하는 회귀선을 구할 수 있다.

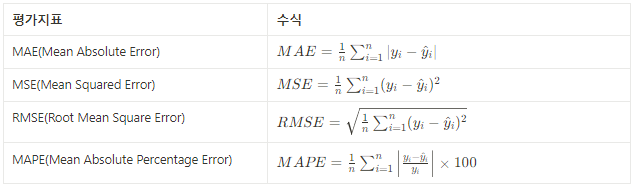

3. 선형회귀 모델 평가

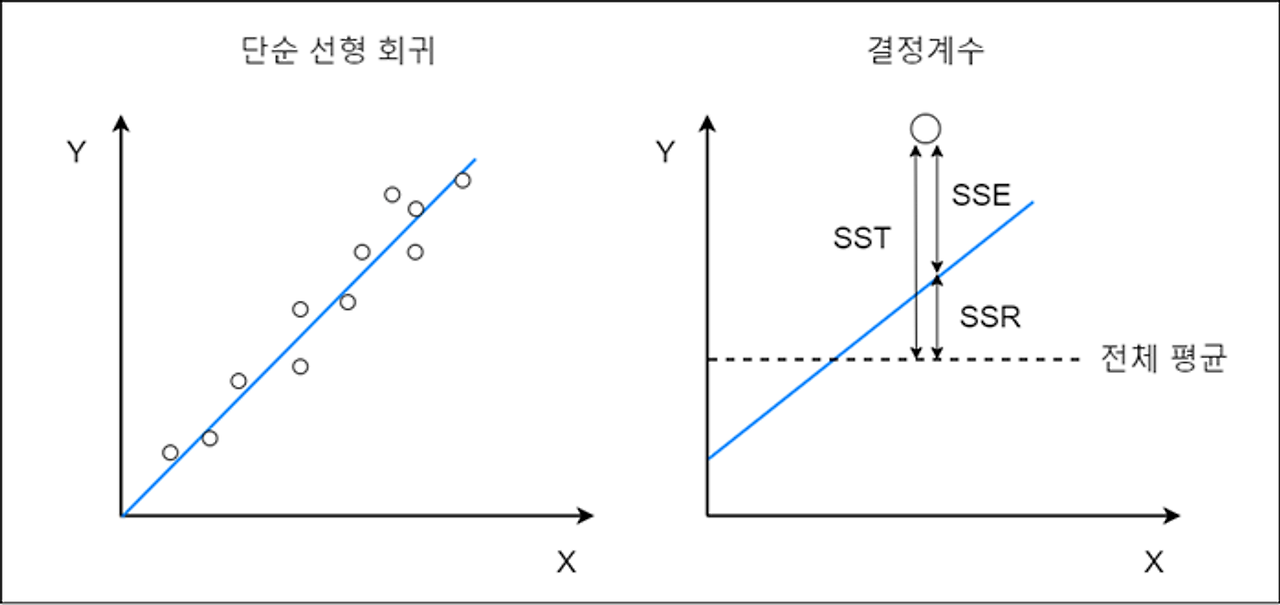

3-1. 결정계수

회귀 직선의 적합도는 결정계수를 통해 추정된 회귀식이 얼마나 타당한지 검토한다. 결정계수가 1에 가깝다면 데이터들이 회귀선에 매우 밀접하게 분포한다는 것이며, 이는 회귀모형이 주어진 자료를 잘 설명한다고 말할 수 있다.

3-2. 평가지표

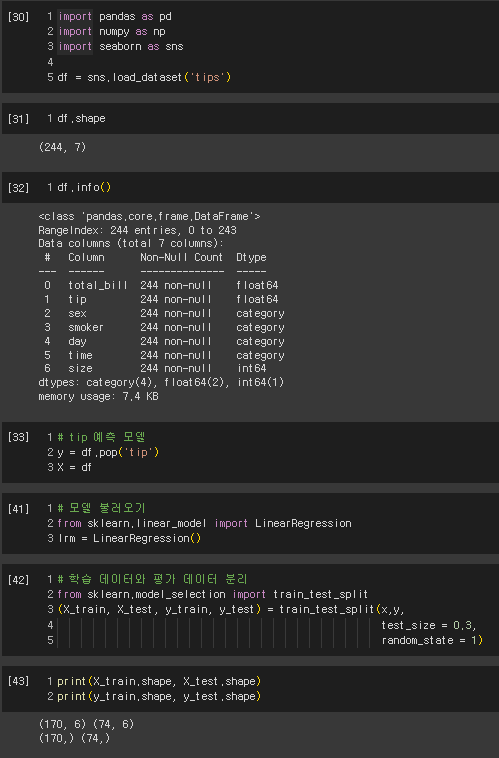

데이터 EDA부터 머신러닝 회귀분석을 다음 데이터를 통해 실습

'머신러닝과 빅데이터 분석 > Machine Learning(지도학습)' 카테고리의 다른 글

| 분류 분석 2 (0) | 2024.03.15 |

|---|---|

| 분류 분석(분류 모델) (0) | 2024.03.12 |

| 머신러닝 (0) | 2024.03.11 |

댓글